【CSDN 编者按】在过去一年,AI 模型的计算能力突飞猛进,但与之伴随的并非成本的持续下降,而是应用层推理开销的急剧上升。曾经以“便宜、无限量”吸引用户的订阅模式,如今正面临限额、降级等现实约束;而重度用户的推理成本甚至有望冲破年均 10 万美元的大关。

原文链接:https://blog.kilocode.ai/p/future-ai-spend-100k-per-dev

作者 | Ewa Szyszka 翻译 | 郑丽媛

出品 | CSDN(ID:C SDNnews)

投稿或寻求报道 | zhanghy@csdn.net

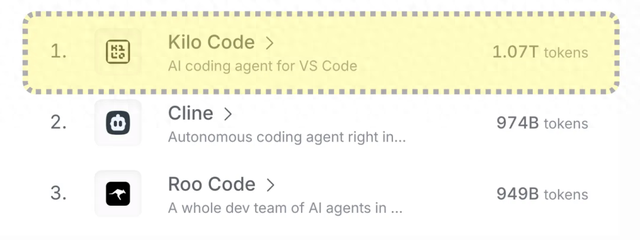

最近,开源 AI 编程工具 Kilo 在 OpenRouter 上首次突破了每月 1 万亿 Tokens 的使用量大关:

同属一个“开源 AI 编码家族”的 Cline、Roo、Kilo,也都在本月迎来了快速增长:

据我分析,促使这种增长的部分原因是:最近 Cursor 和 Claude 陆续对用户收紧了“使用限额”。

(1)今年 6 月,Cursor 宣布对其 Pro 计划取消每月 500 次快速请求限制,改为“无限使用”模式。但事实是:所谓的“无限”仅限于 Auto 模型,其它模型仍按 API 定价,每个月 20 美金的额度,换算下来约 225 个 Sonnet 4 请求、550 个 Gemini 请求或 650 个 GPT 4.1 请求。

(2)今年 7 月,Anthropic 宣布将对 Claude 实施新的每周使用限额。根据官方公告,新的每周使用限额将主要影响 Pro 计划和 Max 计划:

● Pro 套餐(每月 20 美元)每周可用 Claude Sonnet 4 模型约 40–80 小时;

● Max 计划(每月 100 美元)每周可用 Sonnet 4 约 140–280 小时、Opus 4 约 15–35 小时;

● Max 计划(每月 200 美元)每周可用 Sonnet 4 约 240–480 小时、Opus 4 约 24–40 小时。

这波限额把不少用户“赶”进了开源工具阵营,于是就有了本文开头所说的数据陡增——而 Cursor、Claude 之所以要限额,其背后实际是整个行业在 AI Token 经济学(Tokenomics)上的一次错误假设。

行业的“误判”:推理成本会跟着原始成本一起暴跌?

过去一年中,AI 模型的原始推理成本(Raw Inference Cost)确实大幅下降,同比降低了大约 10 倍。这让很多创业公司赌了一把:既然成本下降得这么快,那我现在卖订阅就算亏钱也没关系,明年成本降下来后就能回本甚至大赚。

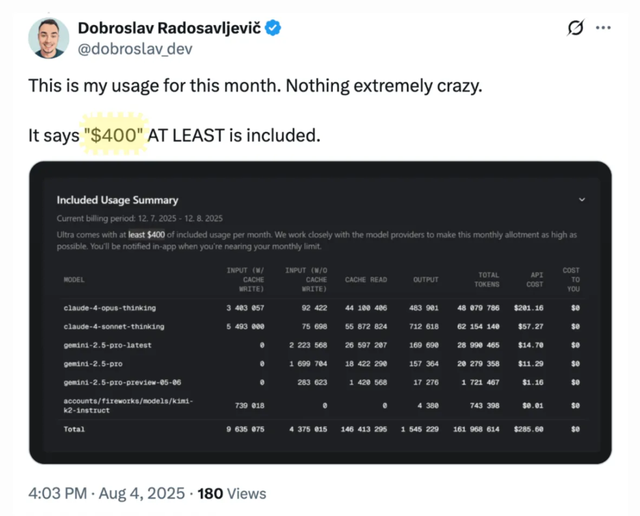

比如,Cursor 的 Ultra 套餐就是经典案例:

● 每月向用户收 200 美元;

● 实际提供的 Tokens 成本价值约 400 美元;

● 直接以 -100% 的毛利率运营。

Cursor 赌的就是一年后推理成本下降 90%,那么同样的 200 美元订阅就能带来160 美元的毛利润(+80% 毛利率)——结果,这事儿压根没发生,应用层的推理成本(Application Inference Cost)反而还涨了!

为什么应用推理成本会“爆炸”?

应用推理成本增加主要有两个原因:

(1)前沿模型的单个 Token 成本并没有下降;

(2)每个应用的 Token 消耗量暴涨。

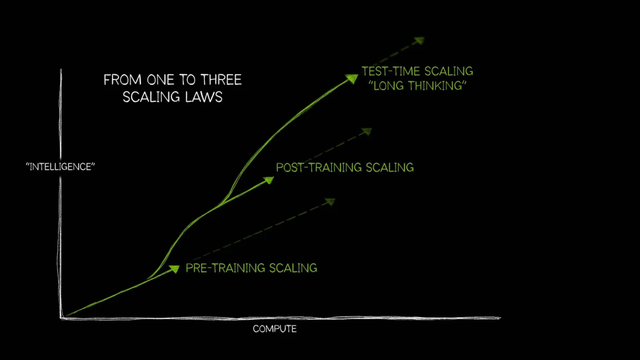

前者是因为模型越做越大,并且引入了推理阶段扩展(Test-time Scaling),也叫长思考(Long Thinking)。相比训练阶段的扩展,这种在推理阶段加计算量的方法会直接推高推理成本。比如 OpenAI 的 o1 系列就是“思考型”模型,在处理复杂问题时,长思考推理阶段的计算量可能是传统单次推理的 100 倍以上。

至于后者,则是因为模型支持更长的上下文窗口、更全面的输出建议,这些都让单次调用消耗的 Tokens 大幅增加。

于是,当单个 Token 的价格稳定 + Token 消耗量飙升时,结果就是:过去两年应用层推理成本涨了约 10 倍。因此,市场龙头 Cursor 推出了每月 200 美元的套餐(此前默认是每月 20 美元),Claude Code 等也紧随其后。

每月 200 美元的“封顶套餐”,导致高强度用户被各种“限制”

如今,AI 工具的高端订阅价普遍封顶在 200 美元左右,与此同时重度用户发现自己被各种“限制”:请求速率受限、被降级到低版本模型、压缩上下文窗口,还有其他各种限制手段。

如果不想受限,用户就得自己掏钱按量付费——而这完全与开源 AI 编码工具家族(Cline、Roo、Kilo)的原则相反:“绝不限制用户”。由于用户直接承担成本,这些工具反而在降低推理开销方面做了很多优化,例如:

1、将任务拆分为多个可高效执行的小任务;

2、多模式协作(例如 Kilo 中有 Orchestrator、Architect、Code、Debug 模式);

3、架构设计任务用闭源模型(如 Sonnet 4),代码生成用开源模型(如 Qwen3);

4、提交前先用 AI 优化 Prompt;

5、使用记忆库提升上下文利用率;

6、启用 Prompt 缓存;

7、在模型出现幻觉时,支持中途终止任务。

尽管已经在努力降低成本,但对重度用户来说,AI 的使用成本依旧在涨。

开发者推理成本或将飙升至每年 10+ 万美元

展望未来,我预计推理成本还会快速上涨,原因有两个:

● 将有更多并行的 AI 代理。例如 Warp 已经向用户开放并行编码代理,未来行业也大概率会将并行代理作为默认功能,这意味着每人每小时的 Token 消耗量将大大增加。

● AI 代理在需要人工反馈前能干更久。因为它们能工作得更多、停顿更少,而这也增加了每人每小时的 Token 消耗量。

这两个趋势一叠加,顶级 AI 用户的推理花费将突破每年 10 万美元(约 72 万人民币)。不过,这个数字放在软件行业也并非闻所未闻——像芯片设计工具 Cadence、Synopsys 的年许可费就有 25 万美元。

别嫌 10 万美元贵,看看训练成本就知道什么叫“烧钱”

事实上,推理阶段的花费只是九牛一毛——对大多数工程师来说,推理成本大约只是 AI 训练阶段的千分之一。

上面提到的“AI推理工程师”年薪可能是 10 万美元,推理花费也是 10 万美元,但生产力能比没有 AI 时高很多倍;而顶级的“AI训练工程师”可能一年花1亿美元训练模型,自己也能拿 1 亿美元年薪。

一般来说,前沿实验室在 AI 训练上投入的是数十亿美元级别的算力,而这些预算仅由少数几个人掌控。有传言称,Mark Zuckerberg 为了挖人,给这些顶尖 AI 训练工程师开出过 1 亿美元到 10 亿美元的签约奖金(合同期限未知)。

因此总体而言,AI 推理工程师和 AI 训练工程师之间的薪酬差异,主要在于他们的相对影响力:

● 训练工程师:少数几个人决定并训练的模型,却被数百万用户使用;

● 推理工程师:只是调用并使用这些模型的环节。

2025 全球产品经理大会

8月15–16日·北京威斯汀酒店

互联网大厂&AI创业公司产品人齐聚

12 大专题,趋势洞察 × 实战拆解

扫码领取大会 PPT,抢占 AI 产品新红利

发表评论